TROCCO #01|初心者でもできる!データ転送手順と設定ポイントを解説!

みなさん、こんにちは。

データ分析やレポート作成を効率よく進めたいけれど、「いろんなサービスのデータをまとめるのが大変…」と感じている方も多いのではないでしょうか?

そんなときに便利なのが、TROCCO(トロッコ)というクラウドETLサービスです。

ノーコードでも操作できるため、非エンジニアやSQL・APIの知識がない人でも扱いやすく、データソース間の転送を自動化できます。また、さまざまなサービスとの連携設定も簡単に行えるのが魅力です。

この記事では、TROCCOでデータを接続する基本のやり方をわかりやすく紹介します。初めて使う方でも設定できるように、ステップごとに解説していきますので、ぜひ最後までご覧ください!

目次

データ転送とは

TROCCOでは、転送元サービスからデータを取得し、必要に応じて加工したうえで、別の転送先サービスへ自動で転送することができます。

データの取得元となるサービスは「転送元コネクタ」、送信先となるサービスは「転送先コネクタ」と呼ばれます。

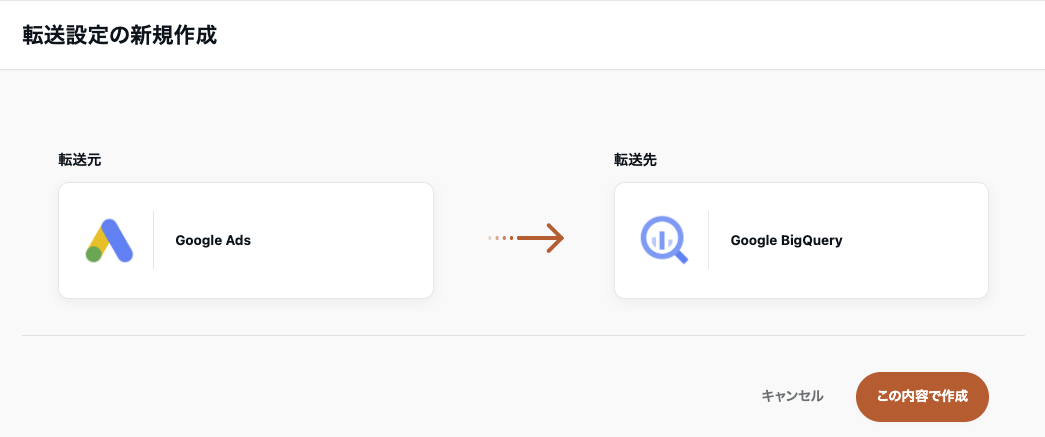

たとえば、転送元コネクタにGoogle Ads、転送先コネクタにBigQueryを設定することで、Googleの広告データを自動的に取得し、BigQueryへ転送する処理をTROCCOが担ってくれます。

TROCCOの主な転送元一覧

【広告系】

- Google Ads

- Google Analytics 4

- X Ads(旧Twitter Ads)

- Yahoo!広告

- LINE広告

- Facebook Ad Insights(Meta広告)

- TikTok Ads

【クラウドアプリケーション】

- Google Analytics 4

- Salesforce

- Backlog

【DWH】

- Google BigQuery

- Amazon Athena / Amazon Redshift

- Azure Blob Storage

- snowflake

【その他】

- HTTP・HTTPS

TROCCOの主な転送先一覧

【クラウドアプリケーション】

- Google Spreadsheets

- Salesforce

【DWH】

- Google BigQuery

- Amazon Athena / Amazon Redshift

- Azure Blob Storage

- snowflake

【広告系】

- Google Ads コンバージョン

- X Ads(旧Twitter Ads)Webコンバージョン

- Yahoo!広告 ディスプレイ広告 オーディエンスリスト

- LINE広告 カスタムオーディエンス/LINE Conversion API

- Facebook カスタムオーディエンス/Facebook コンバージョンAPI

データ転送 新規作成手順

転送設定の新規作成

転送元・転送先を選択し、「この内容で作成」をクリック

転送元・転送先の設定

画面に従い、各設定項目を入力します。

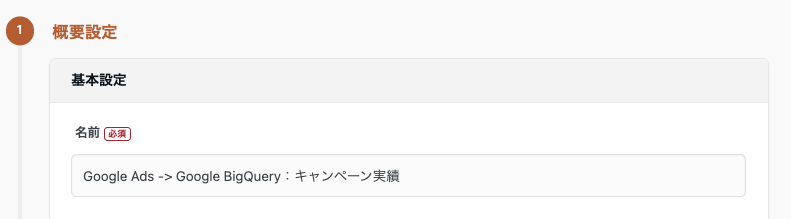

概要設定

【名前】作成する転送設定の名前を入力します

例)Google Ads -> Google BigQuery:キャンペーン実績

転送元の設定

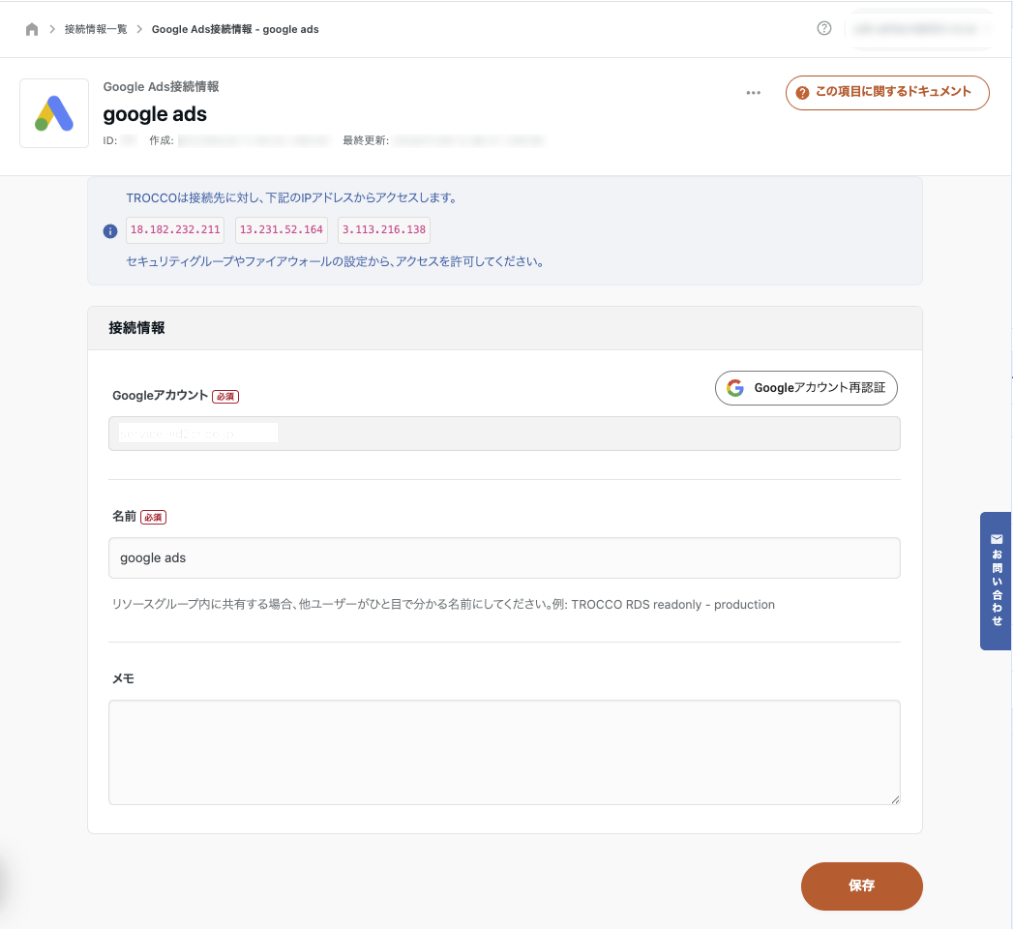

【Google Ads接続情報】接続情報を追加するか、既存の接続情報を選択してください

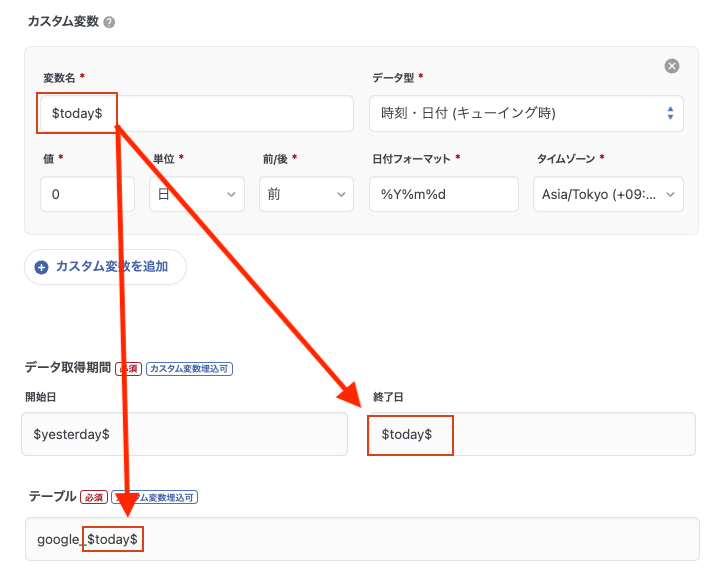

【カスタム変数】カスタム変数とは、設定項目に埋め込むことができる動的な変数であり、ジョブの実行時にその値が自動的に展開されます。

たとえば、変数名に $today$ を指定すると、転送元のSQL文やテーブル名、データ取得期間の条件などに埋め込んで使用することができます。

💡データ型の時刻・日付 (キューイング時) と時刻・日付 (実行時) は、カスタム変数に値を展開する際の基準日時に違いがあります。

時刻・日付 (実行時) :該当ジョブの開始日時が基準。(実際にそのジョブが動き出した時間が基準)

時刻・日付 (キューイング時) :該当ジョブの実行がトリガーされた日時が基準。ワークフローがリトライして再実行されても、基準は 最初にトリガーされた時刻のまま。

スケジュール設定を用いてジョブを実行する場合は 「時刻・日付(キューイング時)」を使うことが推奨されています。ジョブが失敗して翌日以降に再実行されたとしても、カスタム変数には 最初に実行を予定していた日時を基準に値が展開されるため、処理の基準日がぶれずに済むためです。

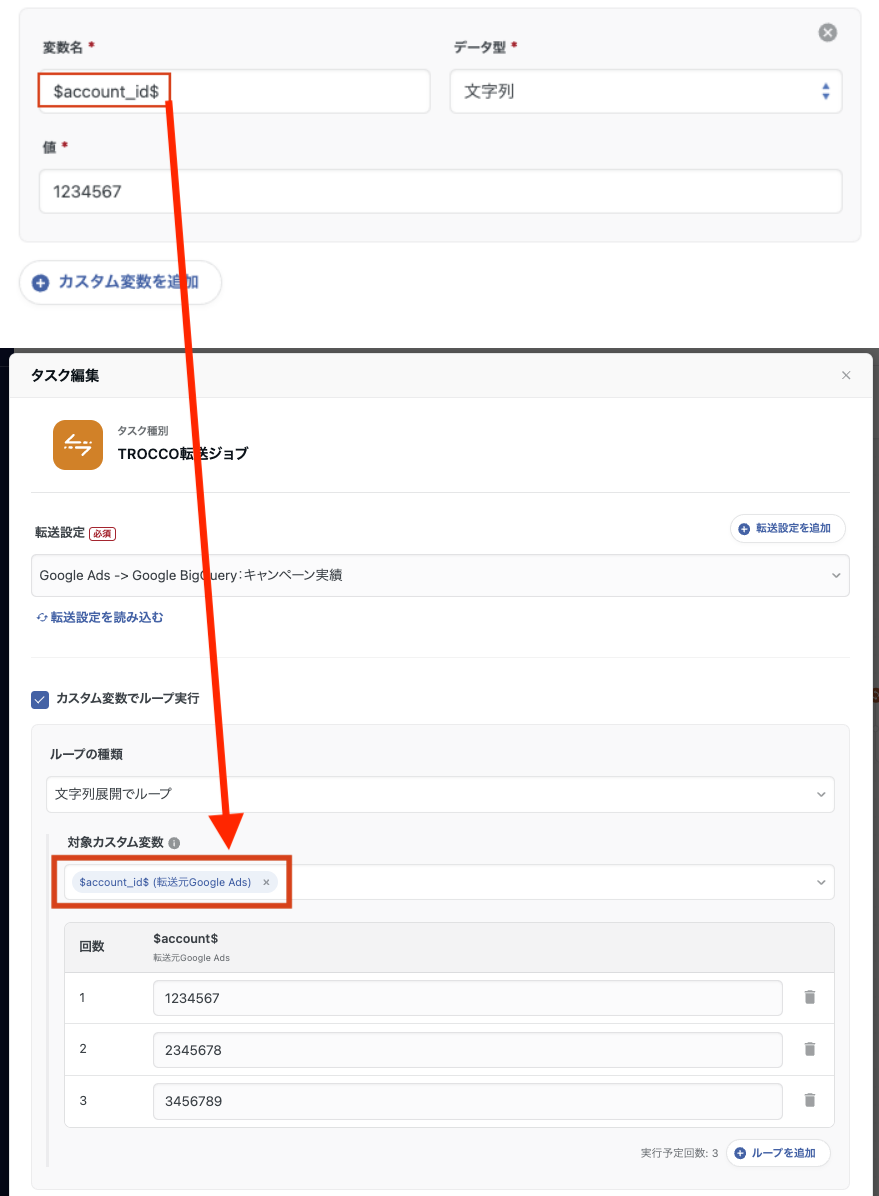

また、変数名に $account_id$ のようなカスタム変数を設定することで、ワークフロー上でその変数に複数の値を順次展開し、同じタスクを異なる値ごとに繰り返し実行(擬似ループ)させることができます。

これにより、1つのデータ転送設定を複数アカウントや条件で動的に切り替えて処理するような柔軟な実行が可能になります。

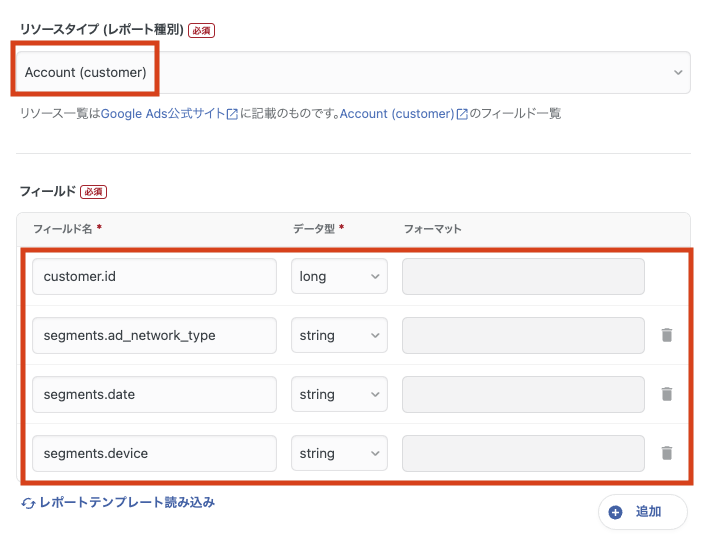

【リソースタイプ/フィールド】転送元のデータ形式によって選択できる内容は異なりますが、取得したい「リソースタイプ」(例:アカウント全体、キャンペーン単位、広告グループ単位、キーワード単位)と、取得する「フィールド」(例:キャンペーン名、クリック数、インプレッション数)を選択してください。

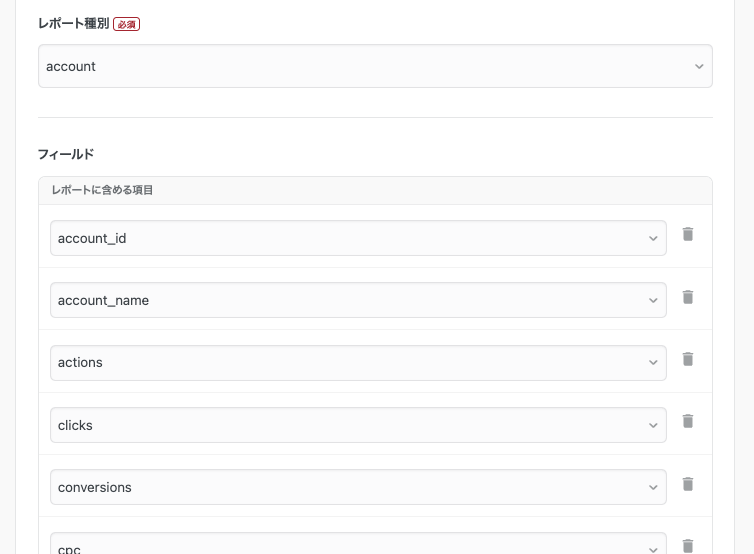

【レポートテンプレート】「レポートテンプレート読み込み」リンクを使うと、データソースやレポート種別に対応した事前定義のフィールドセットを簡単に読み込むことができます。

例えば、Facebook Ads Insightsの転送設定では、「account_id」や「account_name」、「clicks」など、よく使われる主要フィールドをテンプレートから一括で挿入可能です。

なお、すでに手動でフィールドを設定している場合、この機能を実行すると設定が上書きされることがあるため、事前に内容を確認しておくことをおすすめします。

転送先の設定

転送先データによって形式は異なりますが、画面に沿って各設定を記入します。

【Google BigQuery】

【Google Spreadsheets】

転送設定を記入後、「次のSTEPへ」をクリックします。

データプレビュー・詳細設定

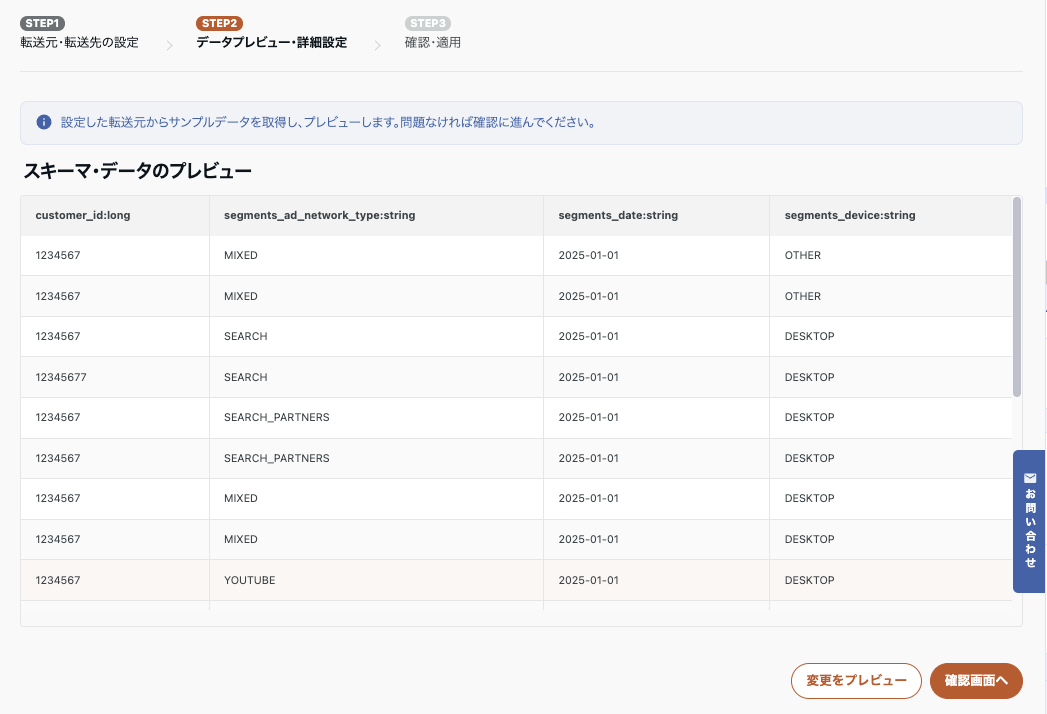

TEP1からSTEP2に進むと、転送データのプレビューが自動的に生成されます。

これにより、転送元サービスから取得される列名・データ型・サンプル値などを事前に確認することができます。

プレビュー完了画面

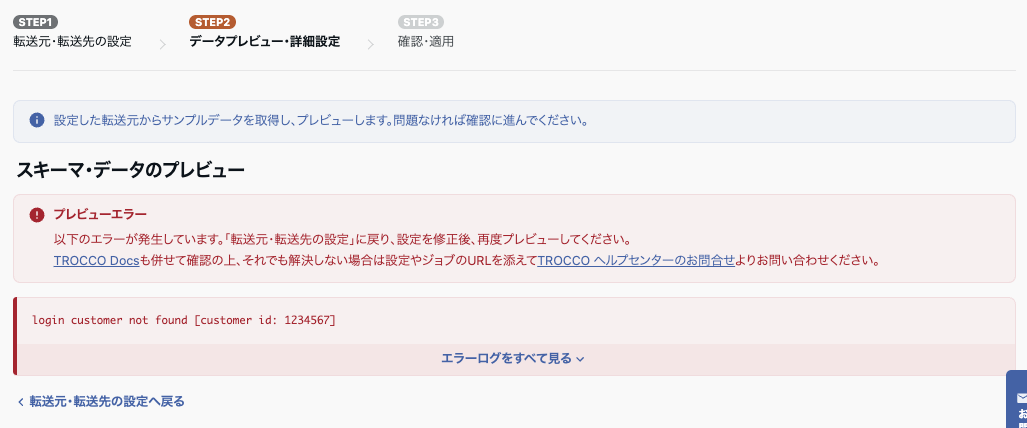

💡プレビュー画面でエラーが発生した場合や、プレビュー結果が期待するデータと異なる場合は、 「転送元・転送先設定へ戻る」ボタンをクリックしてSTEP1に戻り、設定を修正してください。 修正後に再度STEP2へ進む際は、「自動データ設定を実行」を選択します。 ただし、再度プレビューを作成するとSTEP2で行った設定はリセットされるため、再設定が必要になる点にご注意ください。

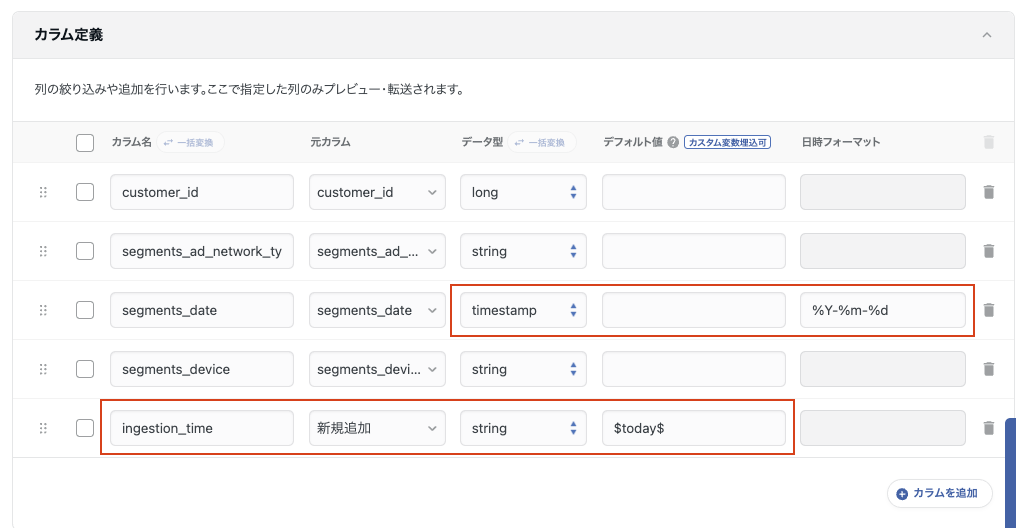

カラム定義

転送されるカラムの追加・削除、データ型の変更、カラム名の定義が可能です。

また、デフォルト値にはSTEP1で設定したカスタム変数を埋め込むこともできます。

設定が完了し、プレビューに問題がなければ「確認画面へ」をクリックしてください。

カラム定義変更の反映有無

TROCCOでは、転送ジョブのカラム定義を変更した際に、転送先であるBigQueryのテーブルを自動で更新することが可能です。これにより、手動でBigQueryのテーブルスキーマを変更する手間を省くことができます。

たとえば既存のテーブルがある状態でカラムを追加した場合、BigQuery側でも自動的にカラムが追加され、既存データの新カラムには以下のいずれかの方法で値を補完する設定が可能です。

-

NULLで埋める

-

デフォルト値(リテラル)で埋める

-

デフォルト値(式)で埋める

また、カラムの削除や型変更にも対応しており、同様にBigQueryのスキーマへ反映されます。

ただし、以下のようなケースでは注意が必要です

-

Looker Studio等のダッシュボードと連携しており、特定スキーマに依存している場合

→ カラムの追加や削除が可視化設定に影響する可能性があります。 -

ワークフローのSQL処理が固定スキーマを前提としている場合

→ 型変更やカラム削除によってジョブエラーの原因となることがあります。

そのため、スキーマの変更に伴う影響を最小限に抑えたい場合は、TROCCOからの自動更新は行わず、後からBigQuery上で手動で更新を行う運用も推奨されます。

また、転送先テーブル名にカスタム変数(${today} など)を使用している場合はスキーマ追従が無効化されるため、その場合も手動で転送先テーブルの設定を更新する必要があります。

スキーマの変更を行う際は、使用しているBIツールや連携している他のデータ処理への影響も考慮し、慎重に対応することが重要です。

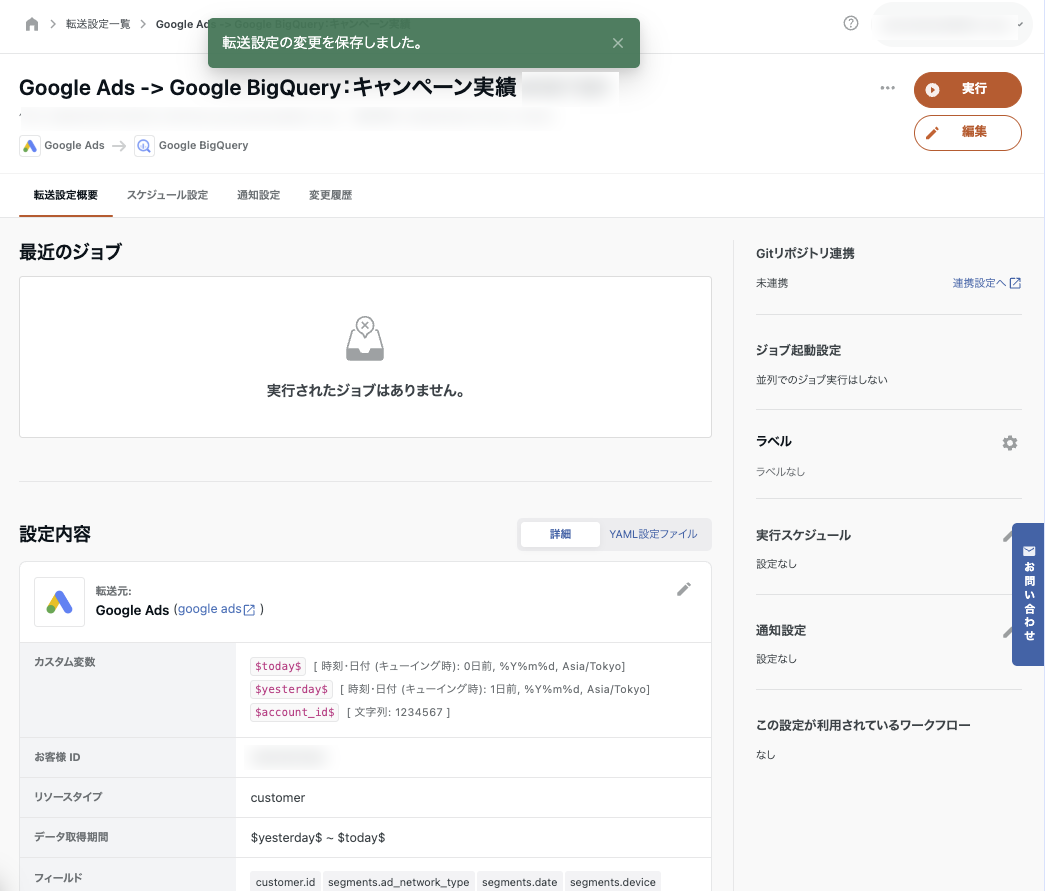

確認・適用

作成した設定の内容を確認し、「保存して適用」をクリックします。転送設定が作成され転送設定詳細画面に移動します。

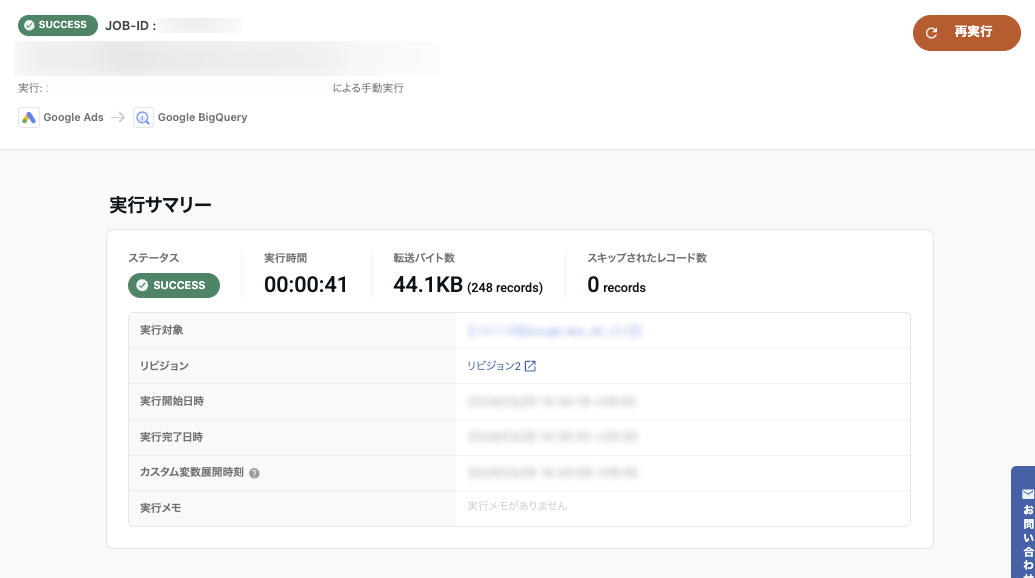

転送ジョブの実行と結果確認

転送設定詳細画面で「実行」ボタンをクリックし、ステータスが SUCCESS に変わったら、データ転送は完了です。

転送されたレコード数やデータサイズ(バイト数)を確認し、意図したデータが正しく転送されているか必ずご確認ください。

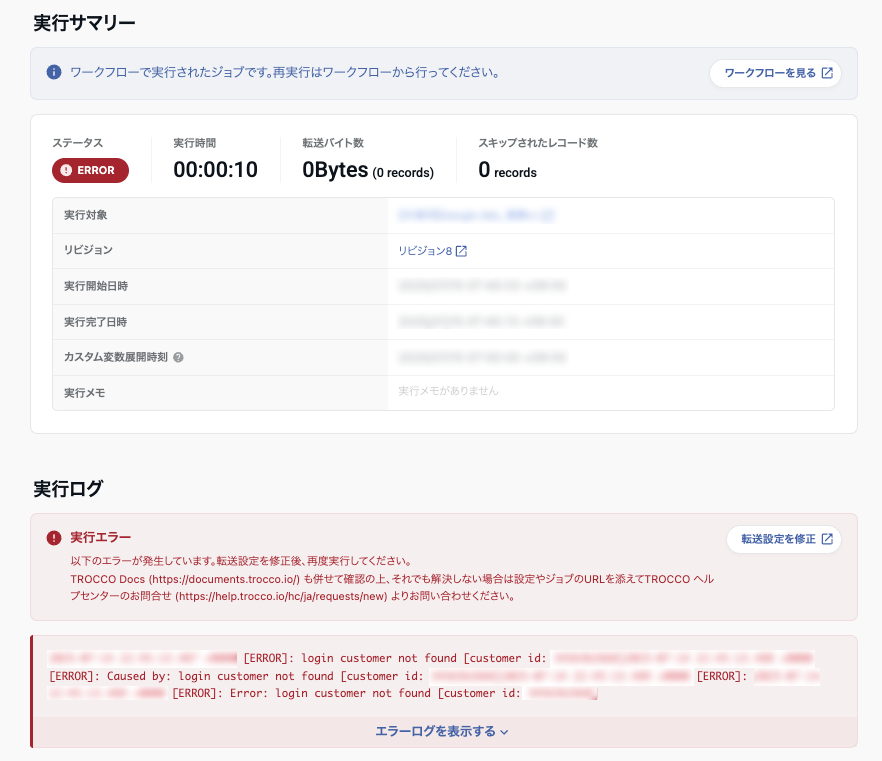

💡データ転送エラーが発生した場合は、まずエラーメッセージや実行ログを確認し、原因を特定してください。認証情報が有効期限内であるか、対象データへのアクセス権限が適切に付与されているか、そして転送データのカラム名やデータ型が転送先のテーブルと一致しているかを順にチェックしましょう。これらの点に問題があれば、転送設定を修正し、再度実行してください。

よくあるエラー

認証エラー(認証情報が無効/期限切れ)

エラー例:認証エラーが発生しました、401 Unauthorized

原因:接続に使っている認証情報(アクセストークンやサービスアカウント)が無効になっている、または期限が切れている

解消法:認証情報を再設定、または再認証を実行する

接続設定(コネクタ)を一度保存し直して再認証を確認する

SQLエラー/構文エラー

エラー例:SQL構文に誤りがあります、Syntax error near...

原因:SQL文に文法エラーがある、またはプレビュー時に使えない構文(変数・関数など)を含んでいる

解消法:SQL構文を再確認(不要なカンマやWHEREの使い方など)

プレビュー用にデータボリュームを制限する(例:LIMIT 10)

$変数$の展開後の値が不正なケースもあるため、展開結果を確認する

データ型の不一致/カラムの不整合

エラー例:型が一致しません、テーブルのカラムが見つかりません

原因:SQLのSELECT句と、後続のSTEP2カラム設定の整合性が取れていない

カラム名の変更や削除を反映していない

解消法:プレビューを再生成することで構成をリフレッシュ

STEP2の手動カラム設定を見直し、一度リセットするのも有効

データアクセスエラー(対象が存在しない)

エラー例:該当するデータが見つかりません、Table not found、403 Forbidden

原因:対象のテーブルやビューが存在しない、またはアクセス権限が不足している

解消法:対象のデータが転送元サービス側で存在しているか確認

認証アカウントに該当データへのアクセス権限があるか確認

カスタム変数の未定義/不正展開

エラー例:変数 $xxx$ が未定義です、無効な日付形式

原因:$today$ や $account_id$ などのカスタム変数が未設定、またはフォーマットが不正

解消法:STEP1で使用しているすべての変数が正しく定義されているか確認

変数のサンプル値を仮で入れて検証するのも有効

データ転送の追加設定

ラベル

ラベルを設定し管理することができます。転送設定を検索する時にも便利です。

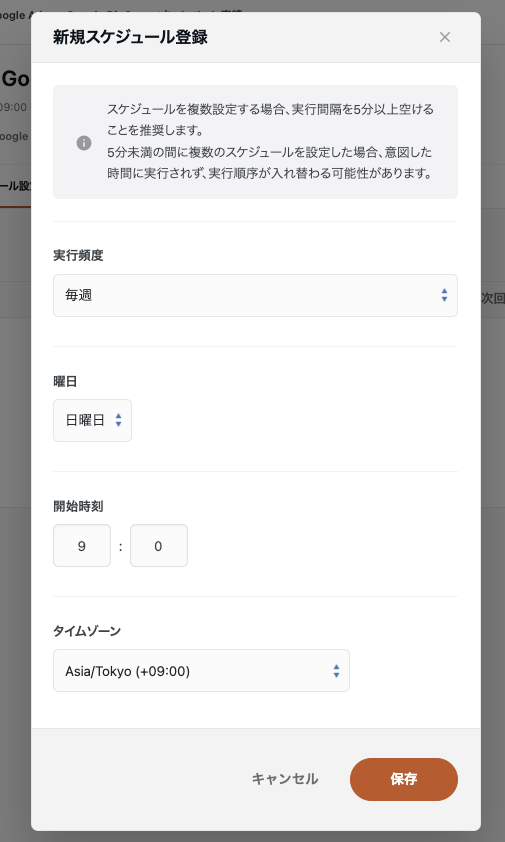

実行スケジュール

転送ジョブの自動実行スケジュールを設定できます。

例えば「毎週日曜日9時に自動でジョブを実行する」ということが可能になります。

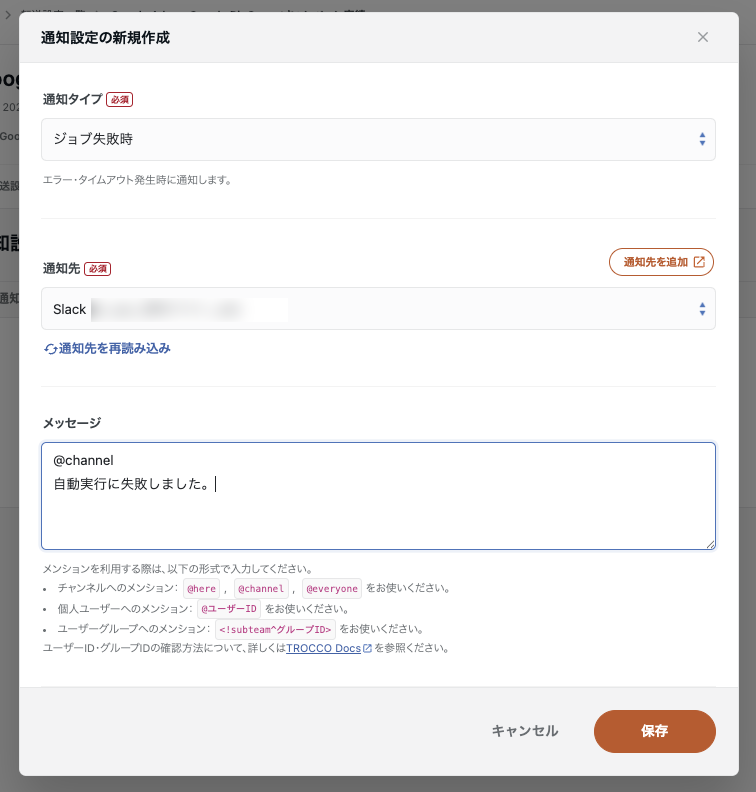

通知設定

ジョブ終了時やジョブ失敗時、レコード数条件に応じて通知を設定できます。

通知はSlackやEmailで受け取ることが可能です。通知先は、新しく作成するか、既存の通知先から選択してください。

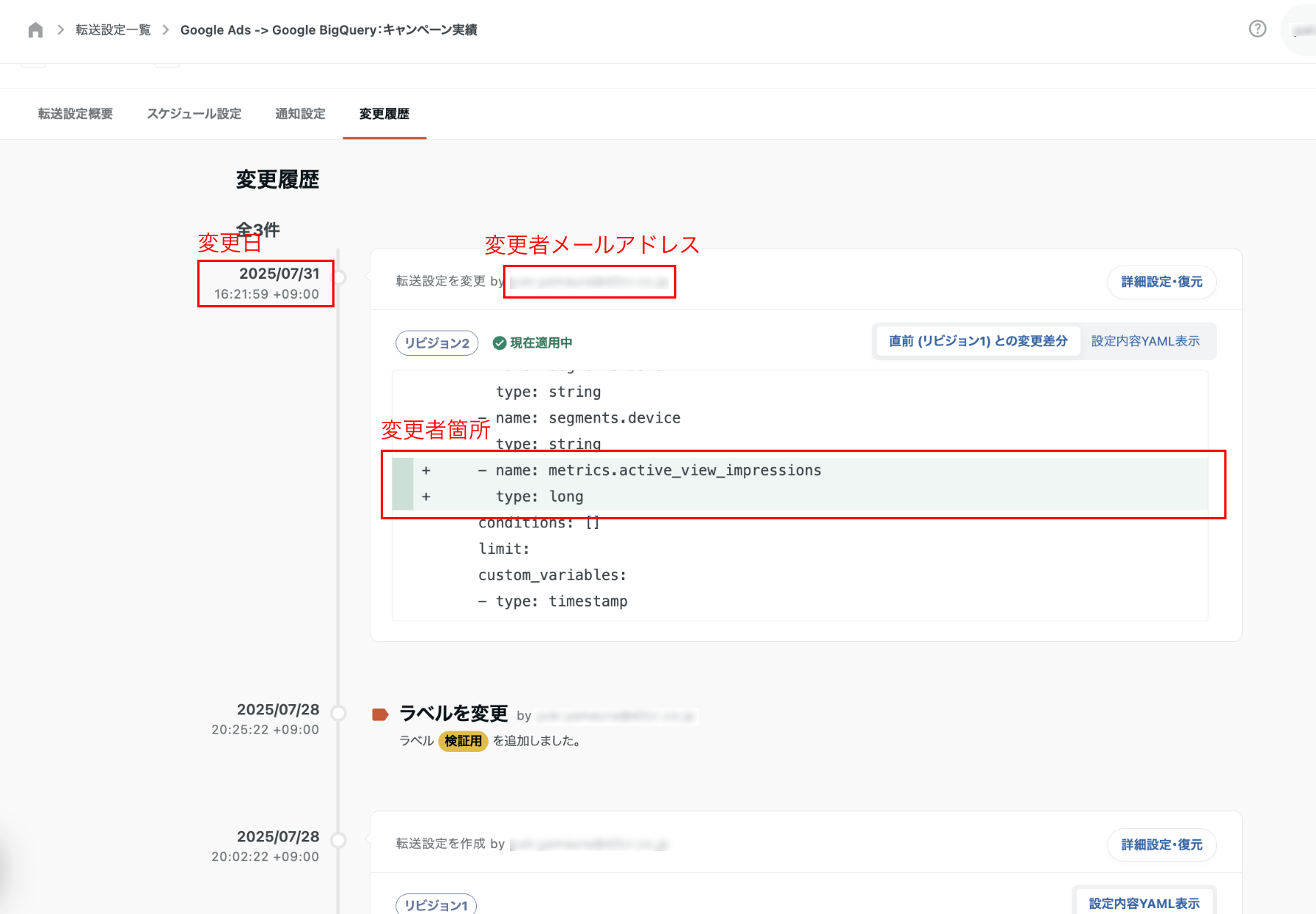

変更履歴

転送設定の変更履歴では、いつ、誰が、どの部分を編集したのかを確認することができます。

リビジョンの「詳細・復元」からは設定を復元することも可能です。

💡リビジョンを復元する際、スケジュール・通知設定などは復元対象になりません。スケジュールや通知に影響がないか確認してから復元するよう注意しましょう。

まとめ

本記事では、TROCCOを用いたデータ転送の設定手順について、初期準備から具体的な設定、スケジューリングや通知設定のポイントまでを一連の流れで解説しました!

実際の業務においても、TROCCOを活用したデータの自動集約・加工と組み合わせることで、より効率的で再現性の高いダッシュボード構築が可能になります。他にもTROCCOのについては、TROCCO(トロッコ)とは?主要機能・特徴・料金・類似サービスとの違いを解説で、主要機能や導入支援についてご紹介していますので、あわせてご覧ください。

またD2C RではTROCCOによるデータ処理基盤の整備から、Looker Studioを用いた可視化・レポーティングの設計・構築まで一貫した支援を行っています。

詳しくはこちらよりお気軽にお問い合わせください。

この記事が参考になった方は「いいね」やシェアをお願いします!

編集者

エンジニアチーム

編集者

エンジニアチーム

GASやLooker Studio、TROCCOなどのツールを活用した、業務効率化やデータ活用のノウハウをわかりやすく発信しています!